83

Octubre 2016

ARTÍCULOS

Los resultados del proyecto IMPALA (Impact Analysis of External Quality Assurance)

Anna Prades - Gestora de proyectos

El proyecto IMPALA, que se lanza en 2013, ha concluido este mes de septiembre de 2016 con la organización de diversas jornadas de difusión en los países participantes. AQU Catalunya enmarcó la difusión del proyecto en una jornada titulada "La evaluación externa de la calidad: ¿para qué sirve?"

Es el momento, por lo tanto, de hacer balance.

¿Por qué hay que evaluar el impacto de la evaluación externa?

La evaluación externa nace en la Unión Europea como un mecanismo para estimular la confianza sobre la calidad de las distintas instituciones de educación superior y, de ese modo, mejorar la movilidad tanto de estudiantes y profesorado como de profesionales (AQU Catalunya, 2003). Así, en la Declaración de Berlín se dice que las agencias de garantía de la calidad están en el corazón del Espacio europeo de educación superior.

Casi veinticinco años después del lanzamiento del proyecto experimental de evaluación institucional (1993), debemos preguntarnos por el rendimiento de unos procesos que han pasado de un marco en el que eran actividades esporádicas a un marco "de febril actividad evaluativa, que ha supuesto la creación de múltiples estructuras orgánicas en distintos países" (Rodríguez, 2013, 21).

El proyecto IMPALA se circunscribe en la corriente de políticas basadas en evidencias, que pretenden no solo rendir cuentas del logro de los beneficios que las impulsan, sino también contribuir a explicar cuáles son las claves de los éxitos –o fracasos– de las políticas, en nuestro caso de las políticas de evaluación de la calidad. Así pues, lo que se pretende no es más que preguntarse qué cambia cuando se lleva a cabo una evaluación externa.

Objetivos

En primer lugar, el proyecto IMPALA tiene por objetivo establecer una metodología común y flexible para la evaluación del impacto de los procesos de evaluación externa de la calidad (EEC). En segundo lugar, la evaluación del impacto tiene que permitirnos conocer el funcionamiento de la EEC. Y, por último, este conocimiento debe contribuir al establecimiento de nuevas políticas de calidad basadas en evidencias.

Metodología

El proyecto tiene un diseño metodológico "antes-después", o sea, se comparan los datos obtenidos antes del proceso de evaluación externa con los obtenidos seis meses después. El objetivo de este diseño es usar los datos previos a la evaluación como aproximación a la situación contrafactual, es decir, el antes nos dibuja cómo estaría la situación sin evaluación externa, y así nos permite "inferir" que los posibles cambios son consecuencia, efectivamente, de dicha evaluación externa.

El marco teórico incluye las teorías de mecanismos causales de cambio social, de modo que se intenta explicar qué elementos de evaluación interna y externa pueden estar detrás de los cambios (Leiber et. al., 2015).

Socios

El proyecto se ha desarrollado en cuatro países de la Unión Europea: Alemania, España, Finlandia y Rumanía. Cada uno de estos países ha aportado, como participante, una agencia de garantía de la calidad y una universidad.

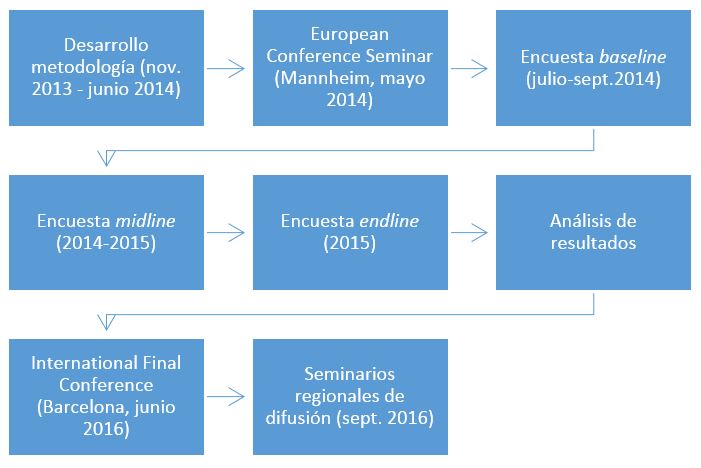

El proyecto IMPALA se inicia con el diseño del cuestionario de evaluación del impacto, fase que culmina con la conferencia "Análisis del impacto de la garantía externa de la calidad en las instituciones de educación superior: metodología y relevancia para las políticas de educación superior", en Mannheim, el 19 y 20 de mayo de 2014 (http://www.impala-qa.eu/impala/index.php/public-events/european-conference-seminar).

Cuadro 1. Fases del proyecto IMPALA

Seguidamente se implanta la metodología con tres encuestas: una antes de la evaluación externa (baseline), otra durante la visita externa (midline) y una última seis meses después de la evaluación externa (endline).

Los resultados de esas encuestas para los cuatro países se presentan en la Conferencia internacional final, en Barcelona, el 16 y 17 de junio de 2016.

Resultados del proyecto IMPALA

En los cuatro países participantes se han encontrado tanto elementos que han cambiado como elementos que no lo han hecho. Más allá de los resultados particulares, que pueden consultarse en la web del proyecto, aquí quiere presentarse un resumen de las principales implicaciones del proyecto para la metodología que usamos en nuestro país.

Para evaluar el cambio en metodologías formativas, hay que evaluar el impacto de otros procesos evaluativos

Los resultados en Cataluña muestran que el proceso de acreditación de las titulaciones no implica cambios en la metodología docente (por ejemplo, una disminución de las clases magistrales).

La explicación de la falta de cambios hay que entenderla en el papel que tiene (y en el que no tiene) la acreditación dentro del Marco VSMA. Así, la metodología se diseña en el proceso de verificación, y su funcionamiento (resultados, satisfacción, etc.) se analiza periódicamente en el seguimiento de los títulos, en función del cual se proponen las consiguientes modificaciones. La acreditación no es el proceso evaluativo para realizar cambios en los programas; de hecho, no puede convivir temporalmente con un proceso de modificación. Más aún, las modificaciones durante el proceso de acreditación parecen incongruentes con un buen funcionamiento del programa formativo (si todo va bien, ¿por qué lo cambias?). En ese sentido, la acreditación no es un buen instrumento para valorar cambios.

Por otro lado, el impacto de la acreditación es muy elevado, porque la consecuencia legal es la licencia para seguir impartiendo, o no, la titulación objeto de evaluación.

La acreditación sirve para incrementar la conciencia de los distintos instrumentos que se utilizan para seguir y mejorar los programas formativos

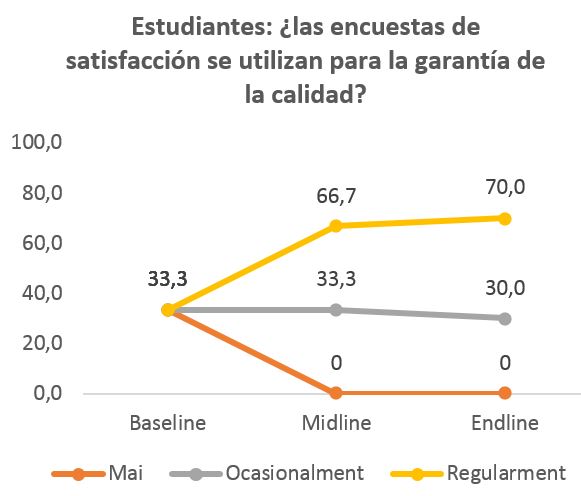

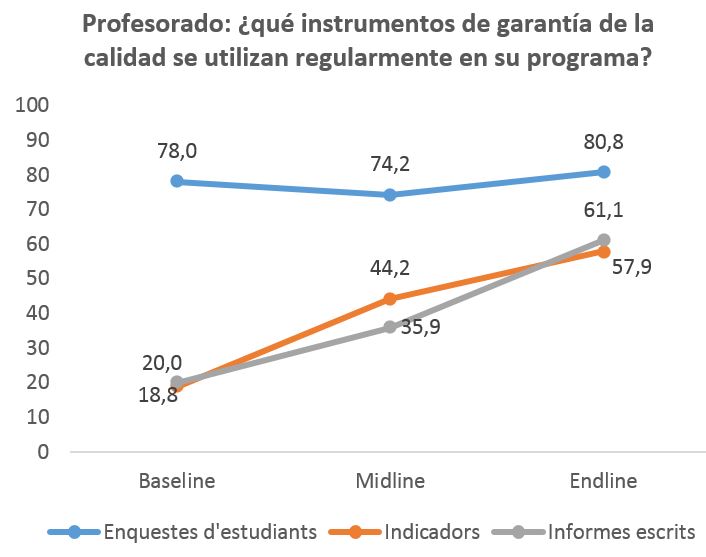

Los resultados muestran que los estudiantes descubren que las encuestas se emplean para el seguimiento de los títulos. El profesorado, por su parte, si bien ya conocía el uso de este instrumento, no era tan consciente del uso de los indicadores e informes escritos como mecanismos de seguimiento y monitorización de la calidad de los programas.

Cuanta más implicación en el proceso de evaluación interna, mejor es la actitud sobre los procesos de evaluación

Los cambios en la actitud del profesorado hacia la EEC se producen durante el proceso de elaboración del autoinforme, y son más acentuados entre aquellos que han participado en la Comisión de Estudios. Estos resultados son congruentes con los resultados de otra investigación llevada a cabo en universidades del sistema universitario catalán: la participación del profesorado en procesos de garantía de la calidad diluye el escepticismo inicial sobre la EEC (Trullen, Rodríguez, 2013).

Perspectivas de futuro (o impacto del impacto)

Qué implicaciones tienen estos resultados y este proyecto en el futuro de las actividades de AQU Catalunya?

La agencia catalana, desde sus inicios, ha entendido la importancia de rendir cuentas de sus actividades. Así, en 2003, ya organizó el seminario "Taking our own medicine: How to evaluate quality assurance agencies". Para mejorar nuestra eficacia, debemos poder no solo medirla, sino conocer qué es lo que funciona y lo que no. Los estudios de impacto nos permiten profundizar en nuestro conocimiento y, por lo tanto, diseñar procesos más eficientes.

La evaluación del impacto supone un considerable cambio metodológico si se compara con las evaluaciones que hemos llevado a cabo hasta ahora del funcionamiento de nuestros procesos evaluativos. Hasta ahora, nuestras evaluaciones, como las de casi todas las agencias europeas, han estado orientadas a mejorar los procesos y se han llevado a cabo una vez finalizado el proceso de evaluación externa (Kajaste et al., 2015).

La participación en este proyecto nos ha hecho darnos cuenta del interés de introducir la perspectiva de evaluación orientada a los resultados, así como de la viabilidad, en cuanto a costes, de introducir un diseño "antes-después". Evaluar el impacto requiere, sin embargo, un diseño de los procesos de evaluación que establezca de forma clara cuáles son los propósitos u objetivos cuyo impacto debe valorarse. Es decir, participar en este proyecto nos ha permitido reflexionar no solo sobre cómo evaluar aquello que hacemos, sino sobre cómo diseñamos los procesos evaluativos.

Referencias

AQU CATALUNYA (2003). Marc general per a la integració europea. Barcelona: AQU Catalunya. <http://www.aqu.cat/doc/doc_20197380_1.pdf>.

IMPALA (2013-2016). Web del projecte: <http://www.impala-qa.eu/impala/>.

KAJASTE, M.; PRADES, A.; SCHEUTHLE, H. (2015). "Impact evaluation from quality assurance agencies' perspectives?: methodological approaches, experiences and expectations". En: Quality in Higher Education, 21(3), pág. 270–287.

RODRÍGUEZ, S. (2013). Panorama internacional de la evaluación de la calidad en la educación superior. Madrid: Síntesis.

TRULLEN, J.; RODRÍGUEZ, S. (2013). "Faculty perceptions of instrumental and improvement reasons behind quality assessment in higher education: the roles of participation and identification". A: Studies in Higher Education, 39(5), pág. 678-692.